EAGLE实验室博士生王子威的论文“History-Aware Reasoning for GUI Agents”、博士生吴之昊的论文“From Coexistence to Collaboration: Unifying Heterogeneous Models for Text-Attributed Graph Learning”、硕士生杨乐洋的论文“ProBench: Benchmarking GUI Agents with Accurate Process Information”、实习生连捷的论文“ Beyond Local Patterns: Multiscale Inconsistency Learning for Graph Anomaly Detection”被AAAI-2026录用。AAAI人工智能会议由人工智能促进会主办,是人工智能领域历史最悠久的国际学术会议之一。近期,AAAI 2026会议录用结果公布,共有23680份有效投稿并进入评审流程,其中4167篇被录用,最终录用率为17.6%。

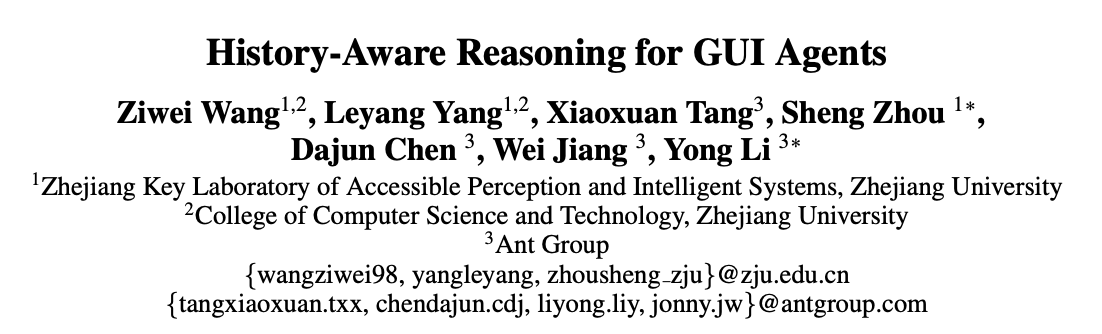

多模态大模型(MLLM)的持续发展增强了GUI自动化的进程。可靠的长交互推理能力是GUI智能体在真实设备上完成用户抽象语义指令的基础。另一方面,历史交互线索的感知与理解是智能体在当前屏幕状态下完成准确决策的关键,它将每个界面与目标导向的情景链相连,有效利用这些线索是准确完成当前决策的关键。然而,现有GUI智能体的显式推理存在短期记忆薄弱问题,即在System2CoT的显式决策过程往往不会利用历史交互信息,将链式交互任务处理成离散的屏幕理解任务,这种历史无感知的(History-Agnostic)推理模式限制了其处理长交互任务的性能。

图(1)GUI智能体短期记忆增强示例图

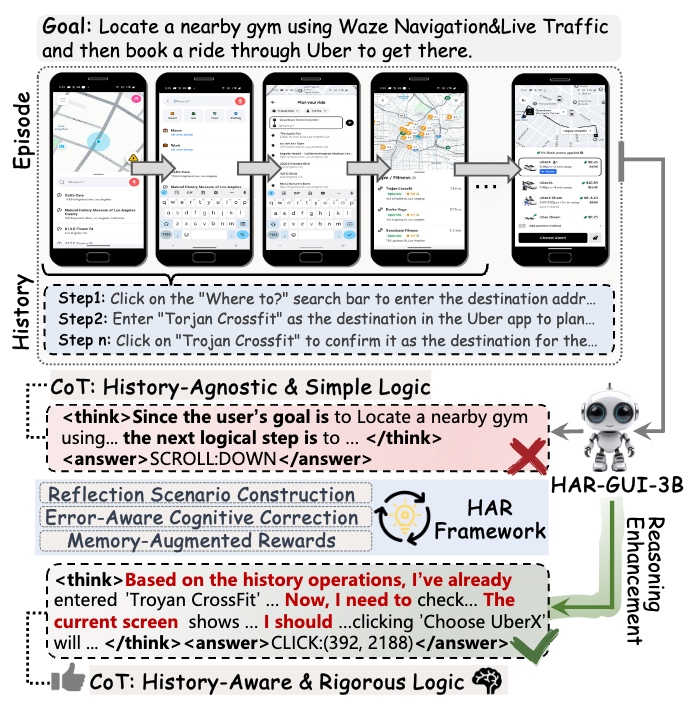

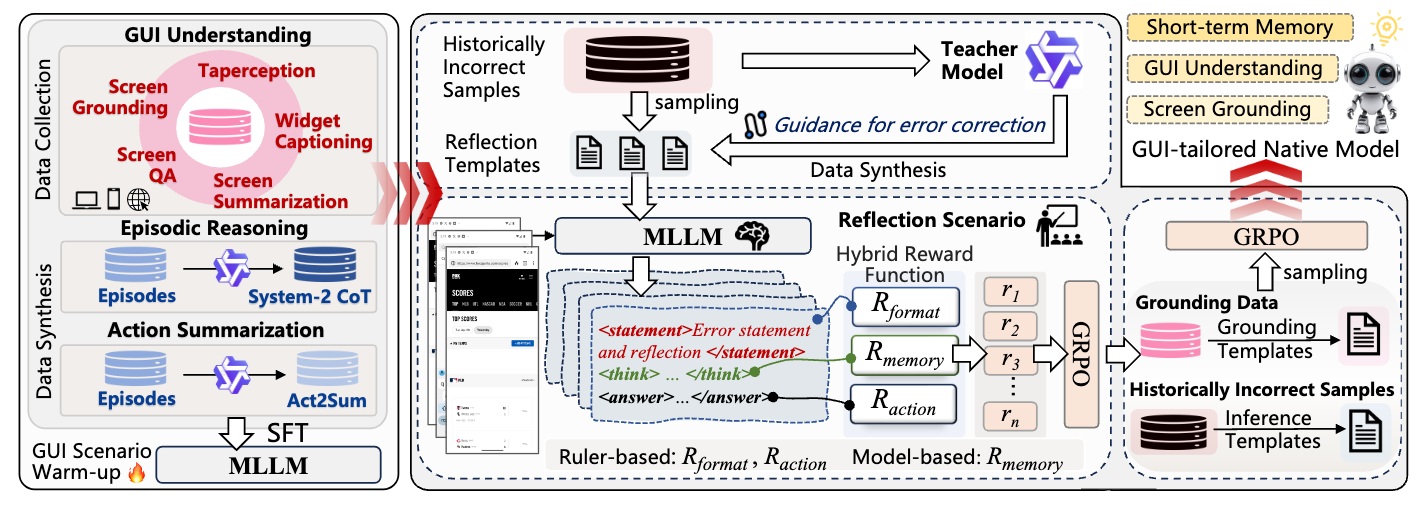

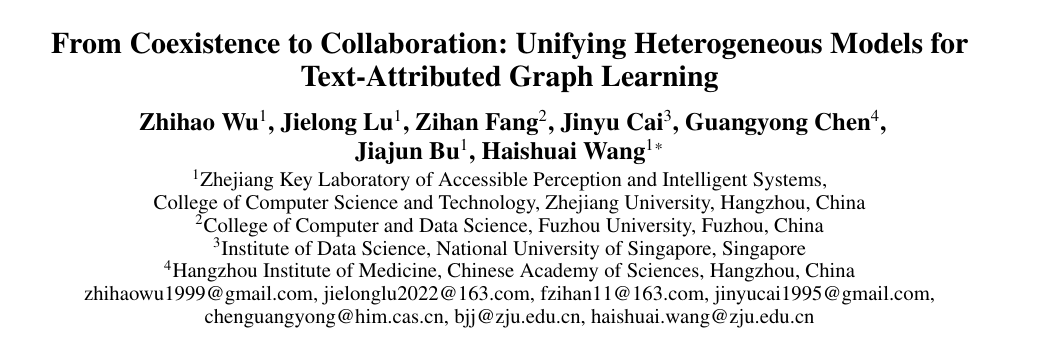

为此,我们提出了一种增强GUI智能体历史感知能力的训练框架HAR(History-AwareReasoning),通过一系列定制化的训练策略增强GUI智能体的短期记忆,引导智能体反思自身错误并从中获取动线推理知识。该框架主要包括构建反思学习场景、合成定制化修正指南、混合RL奖励函数三部分。基于HAR框架,我们训练了一个端到端的GUI智能体—HAR-GUI-3B,将其固有推理模式从History-Agnostic转变为History-Aware,增强了GUI智能体的短期记忆和可靠的屏幕细节感知能力。多项GUI相关基准测试验证了该方法的有效性。Github:https://github.com/BigTaige/HAR-GUI

图(2)历史感知推理(HAR)框架概述

HAR框架是一种以错误为中心的学习方法,旨在通过在定制的反思场景中执行错误感知认知纠正来增强GUI智能体的推理能力。该框架包含两个关键的训练阶段:(i)GUI场景预热阶段。在此阶段,通过收集和综合GUI相关数据,将全面的领域特定知识注入智能体,以进行知识提炼。(ii)从失败中学习阶段。在此阶段,增强智能体的短期记忆。它包括在反思场景中进行一轮强化学习,以执行错误感知认知纠正,从而增强情景推理能力;随后进行另一轮强化学习,采用任务混合训练策略,以帮助GUI智能体感知屏幕视觉细节。

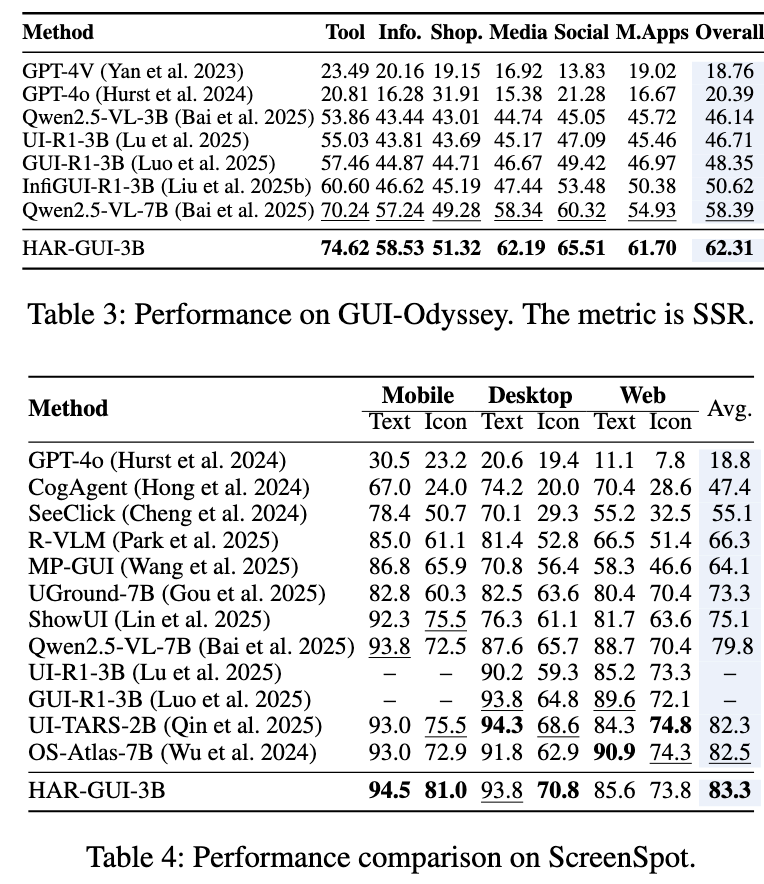

图(3)部分实验结果

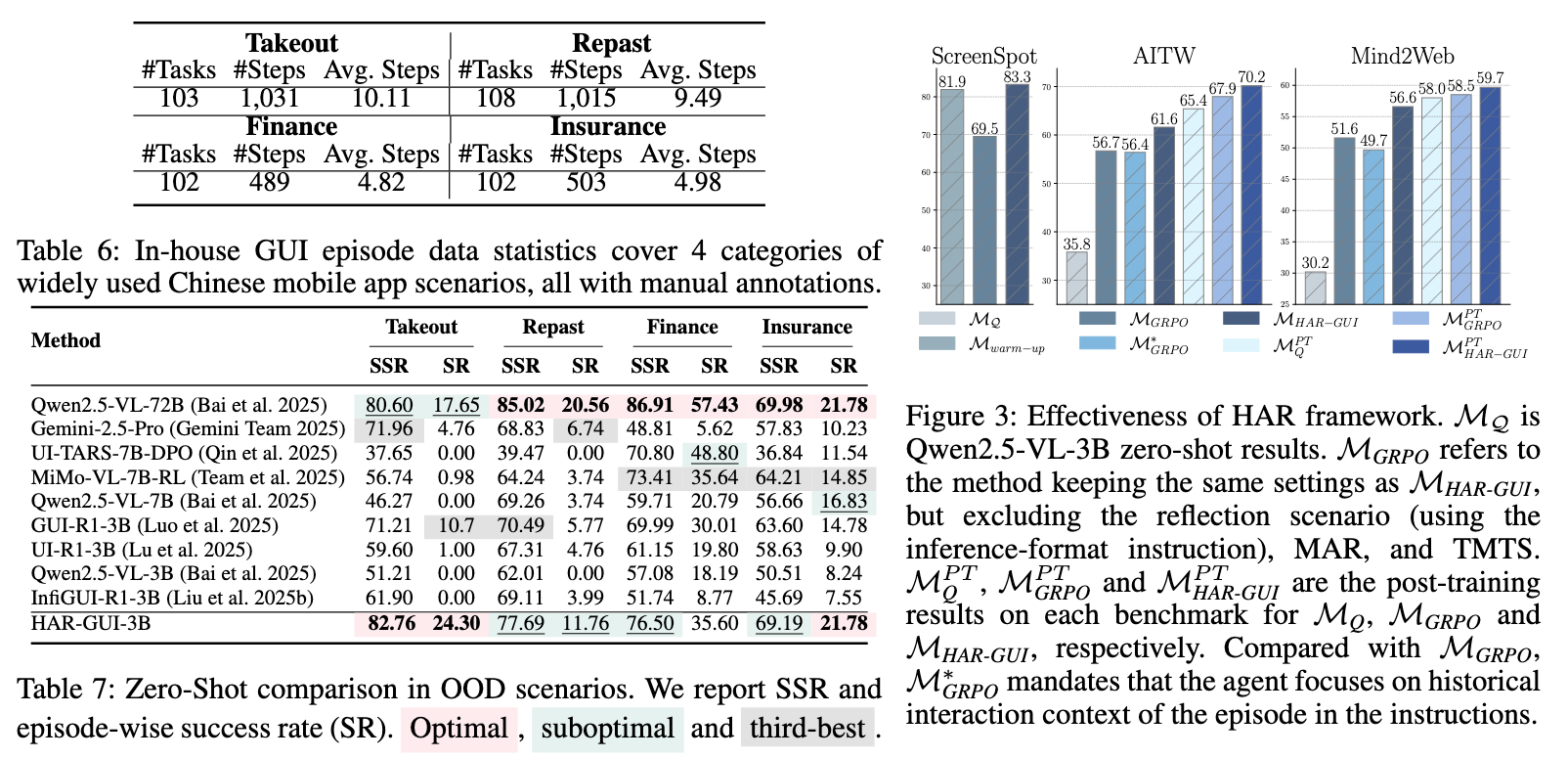

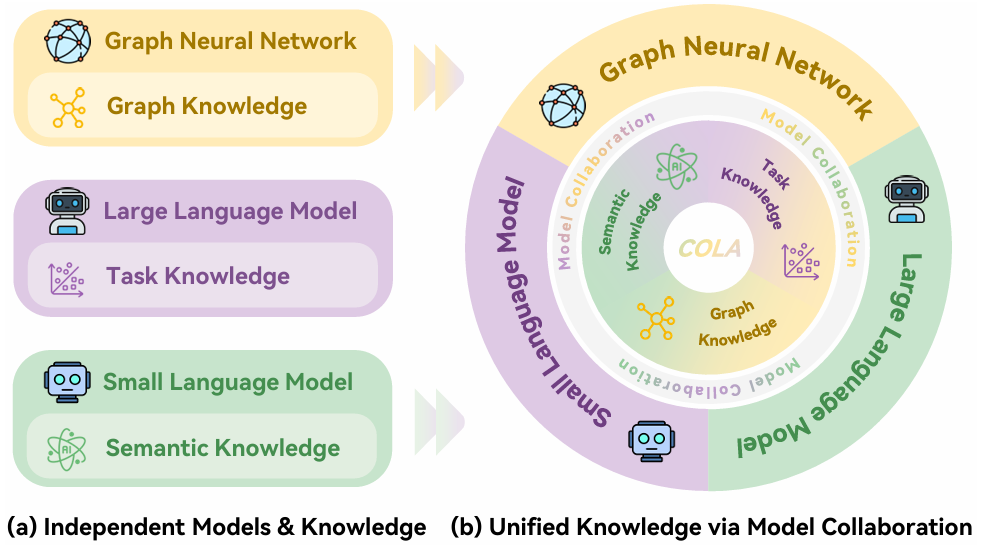

随着图数据规模和复杂性的增加,文本属性图(TAGs)已成为现代图学习的核心。然而,现有的解决方案面临着巨大的“知识鸿沟”:图神经网络(GNN)擅长捕捉结构模式但文本理解能力较浅;大语言模型(LLM)具备丰富的语义知识但缺乏图归纳偏置;较小规模的预训练语言模型(SLM)虽然轻量且易于微调,却常被忽视。现有的“LLM+GNN”或“LLM+SLM”方法往往只是简单的模型堆叠(Coexistence),导致不同来源的知识(语义知识、任务知识、图知识)难以深度融合,处于“知识割裂”状态。

图(1)独立模型 vs 模型协作示意图

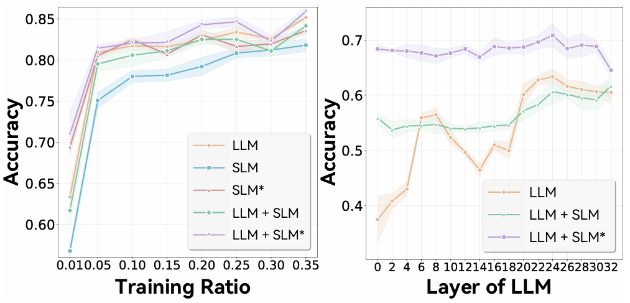

为了探究这一问题,我们首先进行了深入的实证分析。如图2所示,我们对比了LLM、SLM以及它们简单组合(LLM+SLM)在不同训练比例(左)与不同LLM层级(中)下的表现。实验结果表明,简单的模型堆叠并不能带来稳定的性能提升,甚至在部分设置下优于单模型的效果并不显著。这一现象揭示了异构模型间存在知识断层:若缺乏精细的对齐机制,简单的“共存”难以实现互补增强。

图(2)大-小模型简单组合的局限性

图(3)引入图知识后的模型性能对比

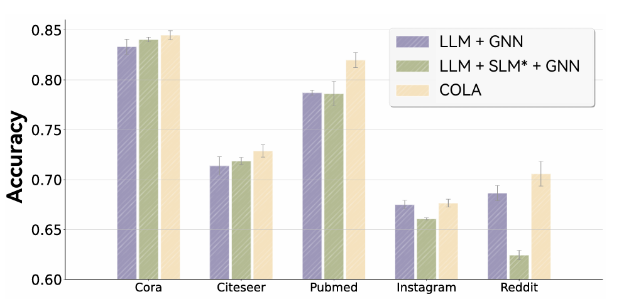

如图3所示,当引入GNN后,协作的难度进一步增加。实验对比了“LLM+GNN”、“LLM+SLM*+GNN”(即包含微调SLM的先进基线)以及本文提出的COLA框架在五个不同领域数据集上的表现。结果显示,即便使用了包含微调SLM的先进基线方法,其在部分数据集上的表现依然不稳定,甚至不如简单的LLM+GNN组合。这表明现有的SOTA框架依然无法有效处理LLM、SLM与GNN三者间复杂的耦合关系。

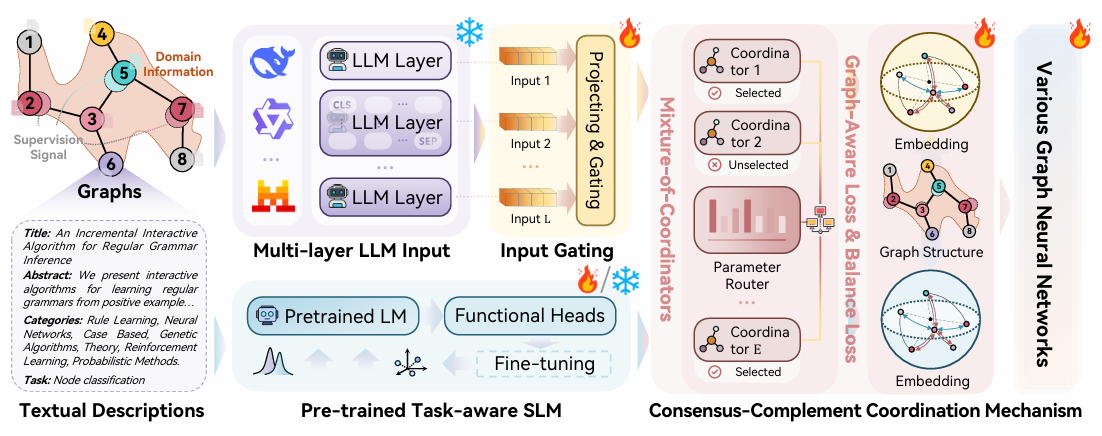

针对上述挑战,我们提出了一种全新的COLA(COlaborative LArge-small model)框架,旨在通过深度的模型协作统一多视角知识。COLA的核心在于设计了一个共识-互补协调机制(CoCo),作为连接不同知识源的桥梁。该机制主要包含两部分:1)混合协调器(MoC):在架构层面,利用混合专家(MoE)思想,自适应地对齐LLM和SLM的表征,既提取共有的语义共识,又保留各自独特的互补知识。2)图知识注入(SGKI):不同于传统方法生硬地将语言模型接入GNN,我们提出了一种基于图感知的联合正则化策略,允许LLM和SLM在对齐过程中“软性”地吸收图结构知识。

图(4)协作式大-小模型(COLA)框架概述。

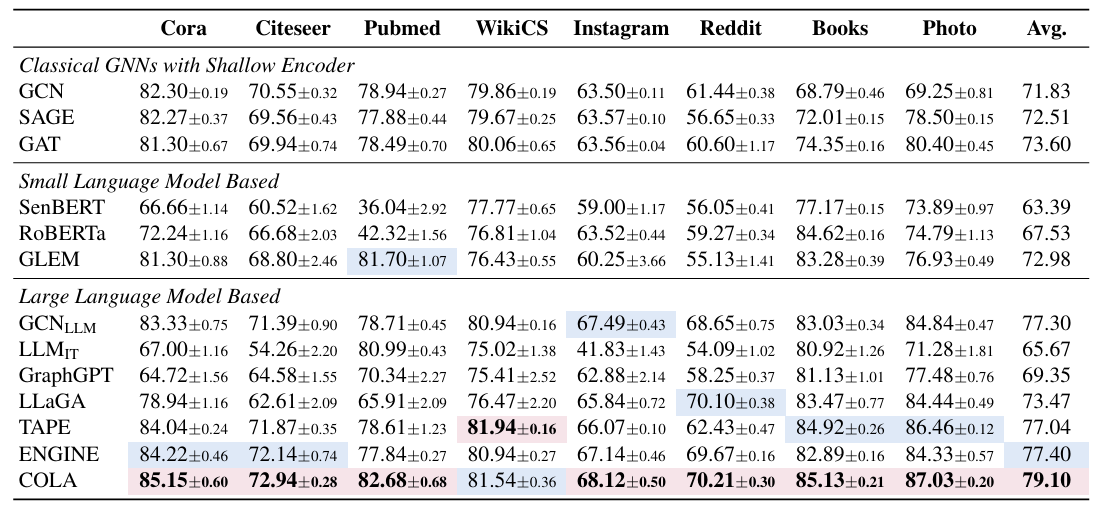

COLA通过Mixture-of-Coordinators (MoC) 模块在架构上对齐LLM和SLM,并通过图知识注入策略实现语义、任务与结构知识的统一。实验数据表明,COLA在所有数据集上均取得了显著优于现有方法的性能。

图(5)部分实验结果

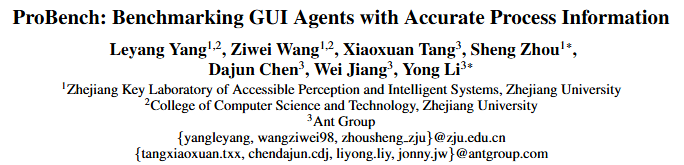

在人工智能与人机交互技术深度融合的背景下,图形用户界面代理(GUI Agent)作为连接自然语言指令与真实设备操作的重要媒介,近年来受到广泛关注。早期研究多聚焦于单张图像的界面元素定位与推理任务;伴随规划、推理与记忆能力的提升,近期工作已探索更复杂的多步操作任务。然而,现有评估方法普遍依赖最终屏幕状态来判定任务完成情况,忽视多步任务中关键中间操作的重要性,从而可能导致实际性能欠佳。例如,在“购买最便宜的无线鼠标”任务中,若省略“按价格升序排序”这一关键操作,即使最终界面呈现了购买确认,仍不能保证所购商品为最便宜选项。尽管部分研究开始关注中间过程信息以改进评估,但现有方案或以牺牲任务规划能力为代价,或受到大语言模型(LLM)在任务分解精度方面的限制。因此,如何准确且自动化地获取过程信息,仍是亟待解决的开放问题。

图(1)现有评估与真实结果之间的差异

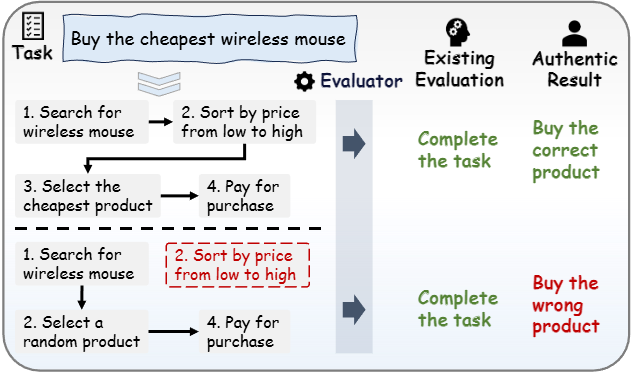

为弥补这一不足,本研究构建了ProBench,一个包含200余个具有挑战性的GUI任务的综合移动基准,涉及34款主流中英文在线应用,覆盖媒体、新闻、社交、购物等多种现实使用场景。为了进行全面评估,ProBench同时包含状态相关任务与流程相关任务,其中前者将所有必要信息呈现在最终截图中,使得性能可仅基于最终屏幕状态进行判定;后者则对操作流程的准确性提出更高要求,必须在结合最终状态的同时验证关键中间步骤(例如启用价格筛选器或设定收货地址)才能准确评估。为实现过程信息的自动化与精准获取,ProBench引入了流程提供程序,该程序包含结构描述转换器用于解析页面层级信息,以及基于多模态大语言模型(MLLM)的摘要器用于通过屏幕对比检测概括关键变化。通过上述设计,ProBench能够评估GUI代理严格捕获和执行必要操作过程的能力。

图(2)ProBench基准测试概述

ProBench是一个综合性的移动基准测试,包含三个关键模块:(i)任务筛选:我们选取了34个主流双语应用,使用LLM生成候选任务,并通过人工审核进行完善。(ii)动态环境:智能体通过控制设备完成指定任务。(iii)评估流程:对于流程相关的任务,我们可以选择使用流程提供器的结构描述转换器或基于MLLM的摘要器来提供流程信息。最终评估由从评审组选出的评审员执行。

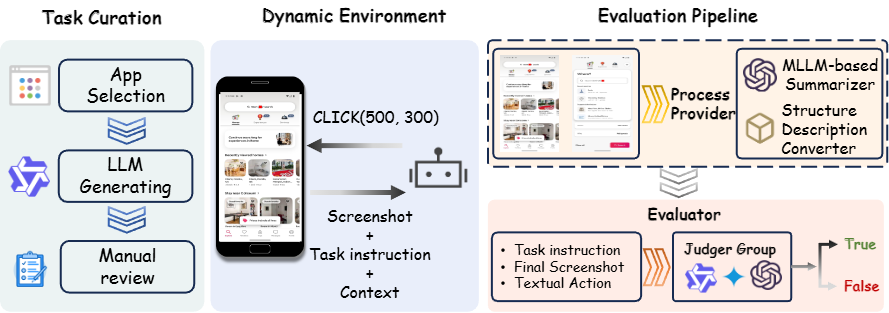

评估结果表明,现有GUI代理在真实场景中普遍存在显著局限性,且在不同类型的模型中均有体现,包括大规模通用模型以及相对小型的GUI专用模型。进一步的分析发现,GUI代理在应对社交类及生活方式类应用任务时表现尤为不理想。深入的错误分析,揭示了若干较为普遍的问题,包括界面元素定位与语义对齐(Grounding)能力不足、对历史交互信息的利用不充分以及任务规划策略过于简单。这些发现不仅反映了现有模型在复杂多步交互中的不足,也为后续在GUI代理的感知、记忆与规划能力方面的优化指明了方向。

图(3)先进GUI Agent的评测结果

随着金融风控、社交平台安全、反欺诈等领域的风险复杂性快速提高,图异常检测已成为保障智能系统可信性的重要技术。尽管近年来在图表示学习范式的推动下,无监督图异常检测取得了显著进展,但直接套用这些图学习范式与异常检测的核心目标在本质上并不一致,存在根本性的不匹配。

图(1)图学习中GAD面临的挑战。

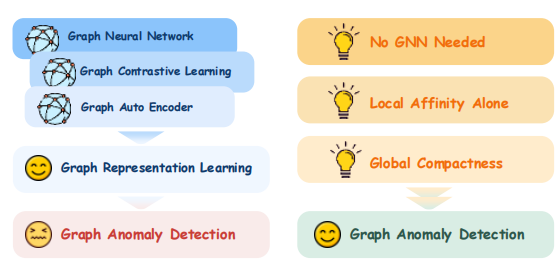

为了深入理解现有 UGAD 方法的局限性,我们首先进行了系统的实证分析。如图2所示,我们分别对比了 GNN 与 MLP 在两类主流无监督异常评分(重构损失与局部亲和力)下的表现。结果显示,GNN的聚合机制不仅未能提升异常识别能力,甚至在多个数据集上出现MLP 明显优于GNN的现象。这一发现揭示了一个关键问题:邻域聚合会稀释异常信号,使 GNN 作为特征提取器并不适用于图异常检测场景。

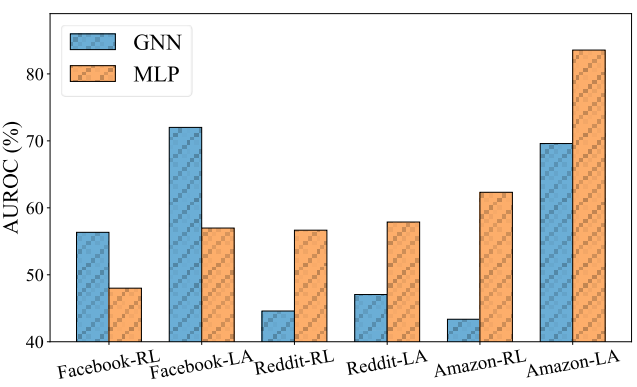

如图3所示,我们进一步观察到真实大规模图中普遍存在“社区伪装”现象:异常节点在局部社区内往往与正常节点呈现几乎相同甚至更高的相似度,导致仅依赖邻域一致性难以有效区分异常。该现象说明局部结构信号本身存在天然局限,难以覆盖伪装社区等复杂模式。综上,我们通过两项预实验提出UGAD的核心见解:1)GNN 在特征层面的平滑偏置会削弱异常表达;2)局部结构信号难以应对伪装社区等复杂异常模式。

图(2)GNN vs. MLP表现差异

图(3)社区伪装现象

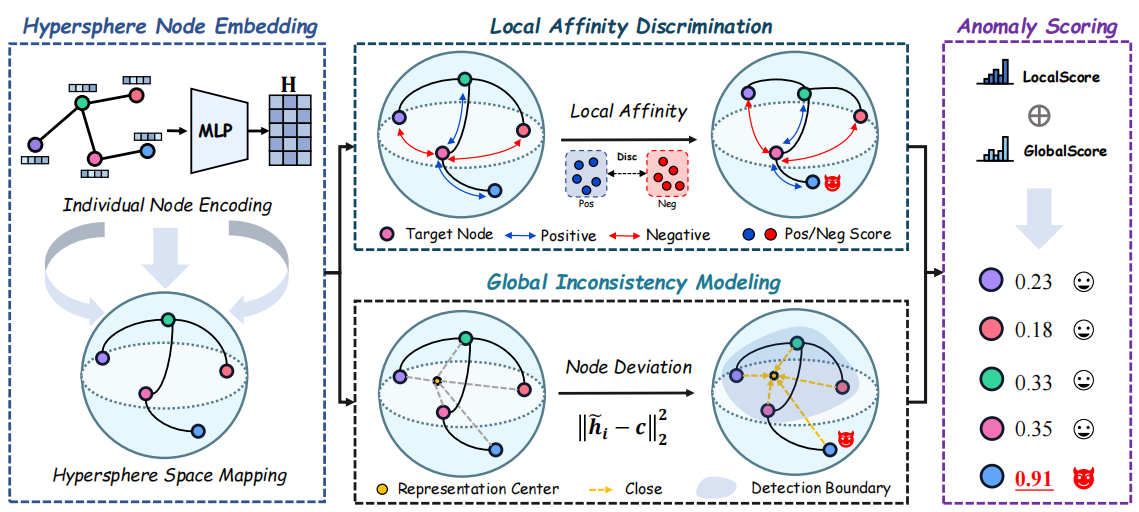

针对上述见解,我们提出了一个全新的 MI-GAD(Multiscale Inconsistency Graph Anomaly Detection)框架,旨在以多尺度视角同时捕获局部结构不一致与全局分布偏移,从根本上克服现有方法的局限。MI-GAD 的核心在于构建一个 局部–全局统一的异常度量机制,实现对不同类型图异常的全面感知。该机制主要包括两个关键设计:1)局部亲和力判别:通过构建正负样本组,显式建模节点的局部一致性模式,使正常节点形成稳定的邻域关系感知,同时放大异常节点的局部冲突信号。2)全局不一致建模:我们引入全新的“节点偏移度”概念,通过度量节点相对于全局表示中心的偏离程度,捕获难以从局部结构中察觉的分布级异常。这两项模块协同作用,使 MI-GAD 能够在无需 GNN 聚合的前提下,实现对局部结构异常与全局语义偏移的深度统一建模。

图(4)多阶不一致学习模型(MI-GAD)框架概述

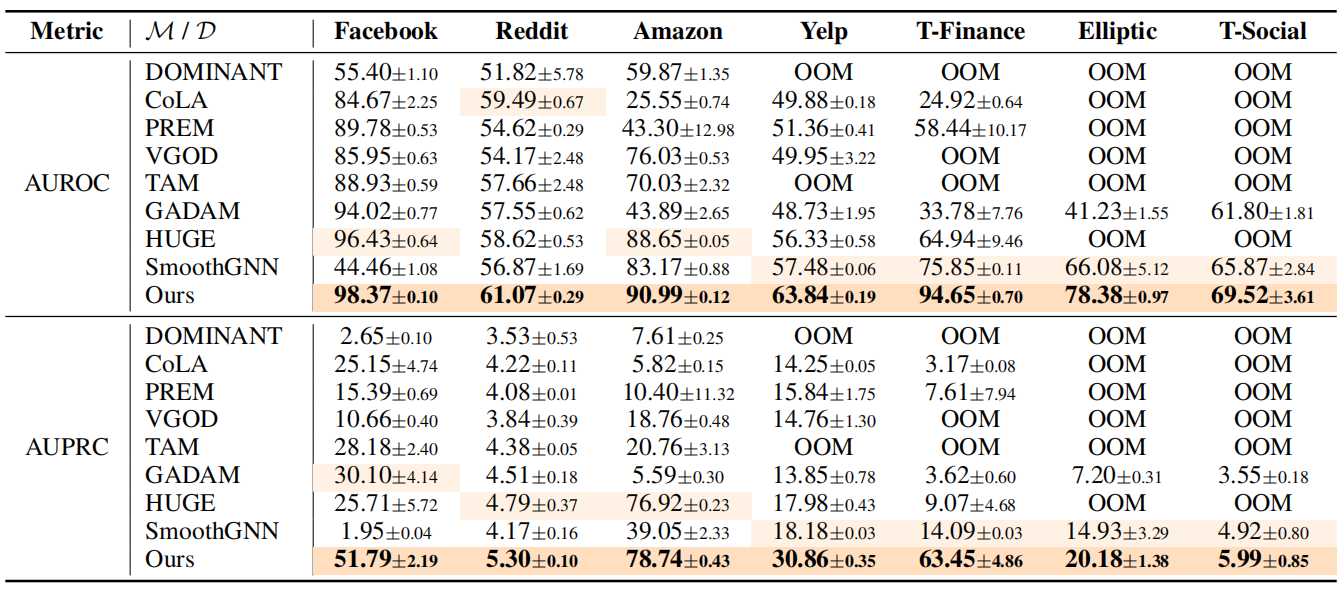

MI-GAD先将节点特征映射到超球面,再做邻域亲和判别并计算节点到全局中心的偏移度,最终融合局部与全局信息得到异常分数。实验结果表明,MI-GAD在所有基线数据集上均取得了显著优于现有方法的性能。

图(5)部分实验结果