近日,EAGLE实验室论文“Graph neural architecture search with large language models”被SCIS录用。

SCIENCE CHINA Information Sciences目前被SCI、EI和SCOPUS等国际数据库收录,最新影响因子为7.6,位于JCR Q1区。2013年和2016年分别入选“中国科技期刊国际影响力提升计划”B类和A类项目;2019年入选“中国科技期刊卓越行动计划”重点类期刊项目;2024年入选“中国科技期刊卓越行动计划二期”领军期刊项目。是科协计算领域、信息通信领域、电子技术领域等高质量科技期刊T1级,是中国自动化学会(CAA)推荐的A+类期刊,中国计算机学会(CCF)、中国通信学会(CIC)和中国人工智能学会(CAAI)推荐的A类期刊,中国电子学会(CIE)推荐的T1级期刊。

为特定的图数据和任务设计图神经网络模型是一项具有挑战性的任务,这一任务需要耗费大量的人力物力并要求从事人员有一定的特定领域知识。现在,图神经架构搜索(Graph Neural Architecture Search, GNAS)已成为自动设计GNN的一种重要的解决方案。图神经架构搜索的基本思想是给定GNN搜索空间,然后在此基础上开发搜索策略,以探索这个空间,找到性能最优的GNN。在过去几年里,研究人员已经研发了很多面向图数据的神经架构搜索方法,但是现有的方法仍然存在一些局限性。例如,绝大多数图神经架构搜索算法的设计依旧需要大量的设计、验证、以及适配,不同的搜索空间也存在很大的差异,这些都会增加人力成本和时间成本。因此,一种GNAS搜索算法在不同的搜索空间中迁移时可能需要大量的手动调整和专业知识,从而增加了人力和时间成本。

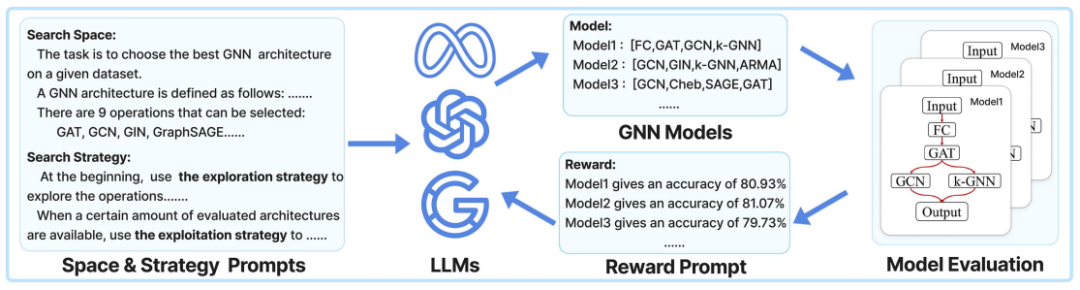

为了解决上述问题,本文提出了一种由大语言模型驱动的图神经网络架构搜索方法。该方法构建了一系列人类可读的提示词,以引导大语言模型在图神经网络架构的搜索空间中持续设计新的架构,通过对已生成的图神经网络架构的性能反馈,大语言模型进一步优化迭代并生成的图神经网络架构,在多轮迭代后,大语言模型输出搜索到的最优图神经网络架构。这种方法可以更有效地处理各种不同的图神经网络架构搜索空间,只需要少量的人工输入,编写简单的人类可读的提示词,就能将搜索算法应用到新的图神经网络架构搜索空间,从而降低了使用图神经网络架构搜索算法的人力成本和技术门槛。本文的贡献如下:(1) 这是将图神经架构搜索和大语言模型进行结合的第一次尝试,并提出了一种新的模型 GNAS-LLM,将 LLM 作为GNAS 的控制器,嵌入到GNAS搜索算法中。(2) 为 LLM 设计了一类新的GNAS 提示。这些提示可以指导 LLM 理解 GNAS 的搜索空间和搜索策略。为了让LLM理解搜索空间,提示使用一个邻接矩阵来描述空间,其中包括候选操作和候选连接。为了让LLM理解搜索策略,提示包括对强化学习的描述,包括探索和开发。(3) 实验结果表明,与现有的 GNAS 方法相比,GNAS-LLM 算法在搜索迭代次数较少的情况下能够生成更好的体系结构,如 GNAS-LLM 算法在测试集上平均减少56% 的迭代次数。本工作代码共享在Github:https://github.com/checkuredu/GNAS-LLM

图1 大语言模型驱动的图神经架构搜索算法示意图

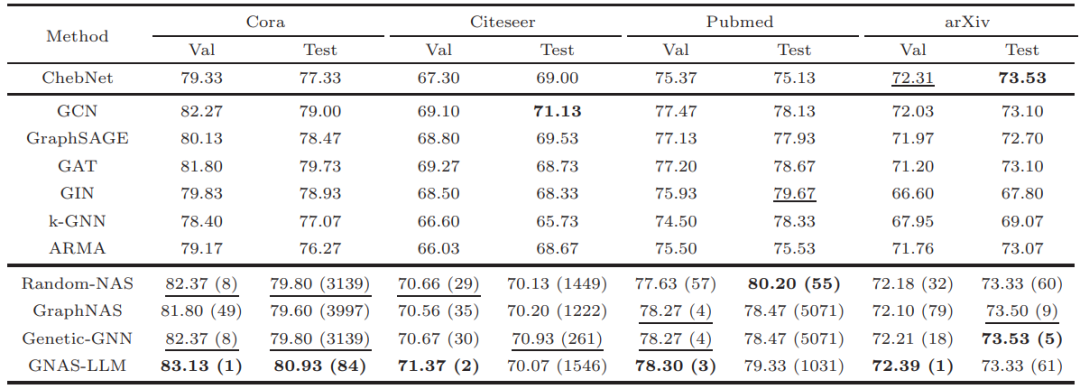

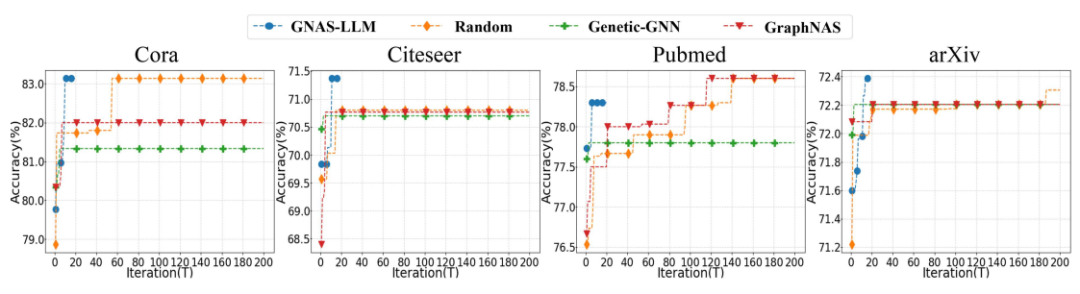

本文所提出的算法在多个数据集和多个搜索空间中进行了验证。通过使用本方法在多个搜索空间中进行架构搜索,并在多个不同的数据集上验证了其性能。为了更全面地评估 GNAS-LLM在图神经架构搜索中的性能,本文在NAS-Bench-Graph提出的搜索空间中,分别在 Cora、Citeseer、Pubmed 和 arXiv 数据集上将GNAS-LLM 与 随机搜索的GNAS、基于强化学习的 GNAS、基于进化算法的 GNAS进行比较。

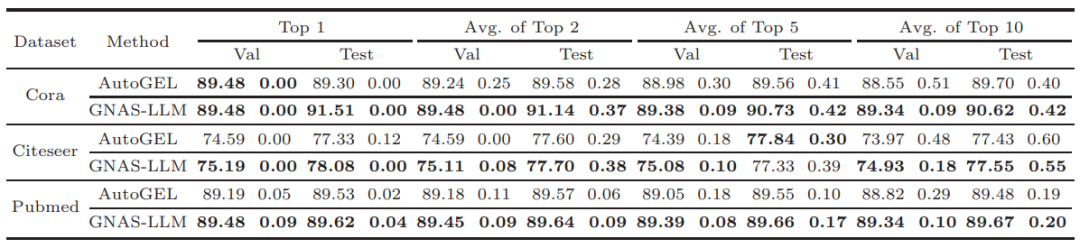

表1 基于 NAS-Bench-Graph 搜索空间的图神经架构搜索实验结果

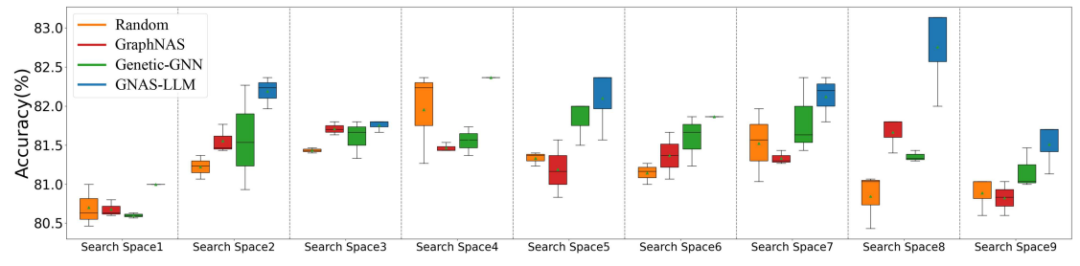

图2 Cora 数据集上,GNAS-LLM 和三个基准方法在九个搜索子空间中设计的 GNNs 的平均准确率 (%) 对比图

如表1所示,GNAS-LLM生成的 GNN 模型在整个搜索空间的验证准确度性能方面处于相对最优。这证明了我们的方法在GNN 设计中的有效性。图2表明我们的方法在九个不同的搜索子空间下比其他方法获得了更高的平均准确率结果。

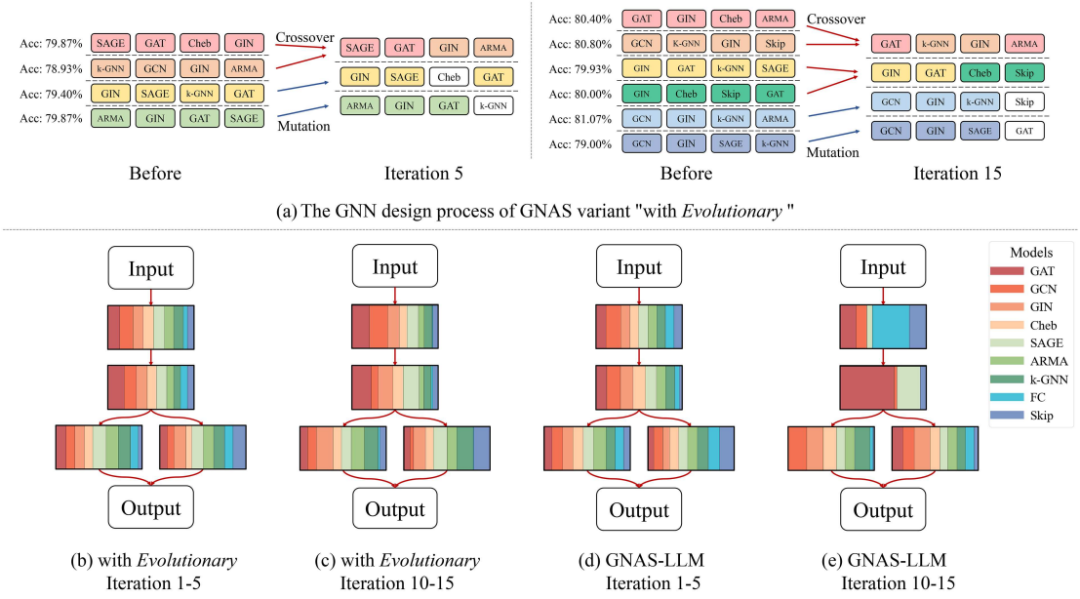

图3 GNAS-LLM根据不同的搜索策略探索架构的偏好

在图3中我们展示了不同搜索策略提示带来的影响。图3(a)展示了使用进化算法提示词之后LLMs在整个搜索过程中使用杂交(Crossover)和变异(Mutation)的操作来生成新的架构的过程。图3(b)-(e)则展示了LLMs在两种搜索策略提示下,在不同搜索阶段展现出的不同搜索偏好。这表明LLM能够理解并执行不同的架构搜索策略;而且可以通过修改搜索策略提示词来设计实现性能更优的搜索算法。

图4 基准方法迭代搜索 200 轮和GNAS-LLM 迭代搜索 15 轮性能变化对比图

图4中展示了我们的方法和迭代更多轮次的基准方法的对比。我们将基准方法的搜索迭代次数设置为200,而我们的方法因为受到 GPT-4 输入提示词长度的限制依旧只进行15次架构搜索。能用更少的迭代次数搜索到出色的架构,这显示出我们的方法在收敛速度方面的优势。

表2 GNAS-LLM 在AutoGEL 提出的搜索空间中进行架构搜索的结果

为了证明本文的方法能够适应各种不同的搜索空间,本文还将 GNAS-LLM 扩展到 AutoGEL 提出的搜索空间上,并与AutoGEL方法进行对比。表2中展示节点分类的实验结果。结果表明,我们的方法设计的最佳 GNN 架构在所有三个数据集的验证集和测试集上都优于现有方法。在其他任务中,例如链接预测,也有出色的表现。