EAGLE实验室2篇论文被计算机视觉领域著名会议ECCV2024录用

European Conference on Computer Vision (ECCV)是计算机视觉领域的著名会议。近期,ECCV2024会议录用结果公布,本次会议共收到8585篇有效投稿,最终录用2359篇,录用率为27.9%。Eagle实验室博士生邵子睿的论文《WebRPG: Automatic Web Rendering Parameters Generation for Visual Presentation》和硕士生张舒奕的论文《Attention Beats Linear for Fast Implicit Neural Representation Generation》被ECCV2024录用。

内容创作领域正经历一场革命,这得益于图像、文本、音频等生成模型的飞速发展。这种进步极大地提高了平面设计领域的工作效率,尤其在广告和杂志设计方面。然而,作为平面设计核心的网页设计自动化,目前尚未受到应有的关注。网页设计在网页视觉传递中发挥着关键作用,不仅关乎用户满意度,还直接影响用户行为。然而,网页设计复杂且耗时,对于技能有限的开发者来说更是一大挑战,常常导致视觉效果不尽如人意。若能实现网页设计的自动化,将大大简化这一流程。

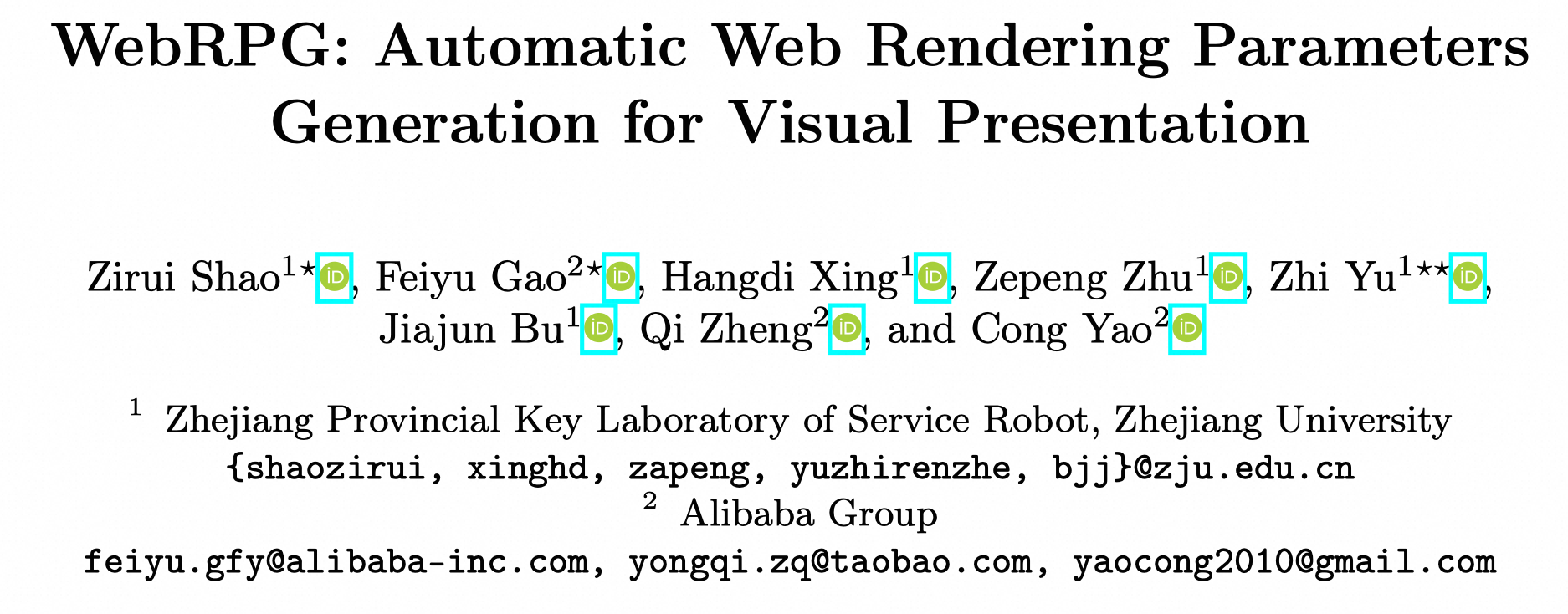

因此,本文提出了一个全新的任务,名为网页渲染参数生成(Web Rendering Parameters Generation, 简称WebRPG)。如下图所示,该任务的目标是根据HTML代码自动生成每个网页元素的渲染参数。所谓的“渲染参数(Rendering Parameters, RPs)”是一组由CSS属性定义的关键参数,决定了浏览器中网页元素的视觉外观。通过WebRPG系统,HTML成为获取有效网页视觉表达的唯一前提,这有加快网页开发工作流程的潜力。借助大语言模型,WebRPG系统甚至能实现完全自动化的网页开发工作流程。此外,它还能促进新应用的发展,例如高效地探索不同的设计选项和动态个性化网页样式。

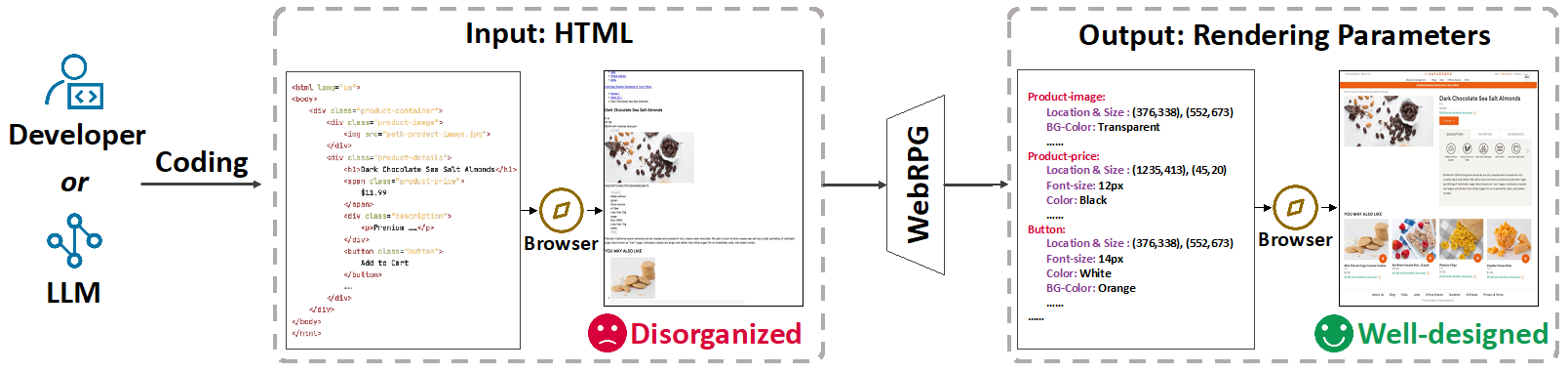

由于WebRPG任务缺乏现有的数据集,本文设计了一套自动化的数据处理流程,将原始网页转换为规范的样本,并利用开源数据集创建了一个新的数据集。下图展示了一些样本。

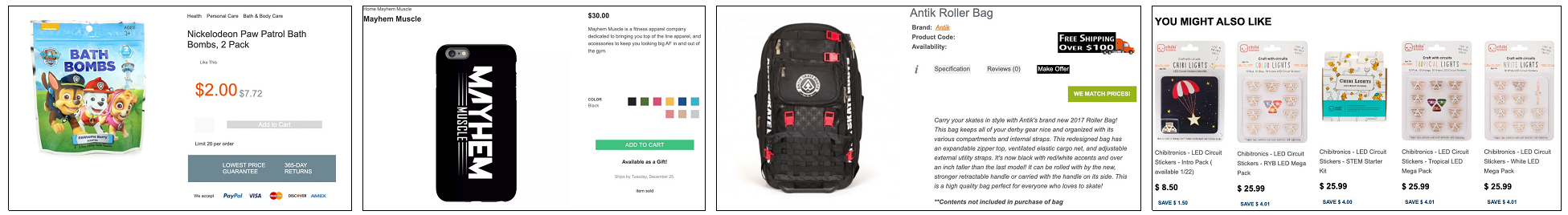

WebRPG任务面临两个主要挑战:首先,网页包含数百个元素,每个元素都具有许多渲染参数。其次,网页元素的视觉表达需要与HTML代码提供的语义和层次信息相关联。为了解决这些挑战,本文采用了变分自编码器(VAE)来处理大量的渲染参数。同时,引入了特别设计的HTML embedding来编码语义和层次信息,涵盖三个维度的信息,即语义、层次和字符数量。基于这些模块,本文建立了两个WebRPG基线模型,一个是基于自回归模型,另一个是基于扩散模型。

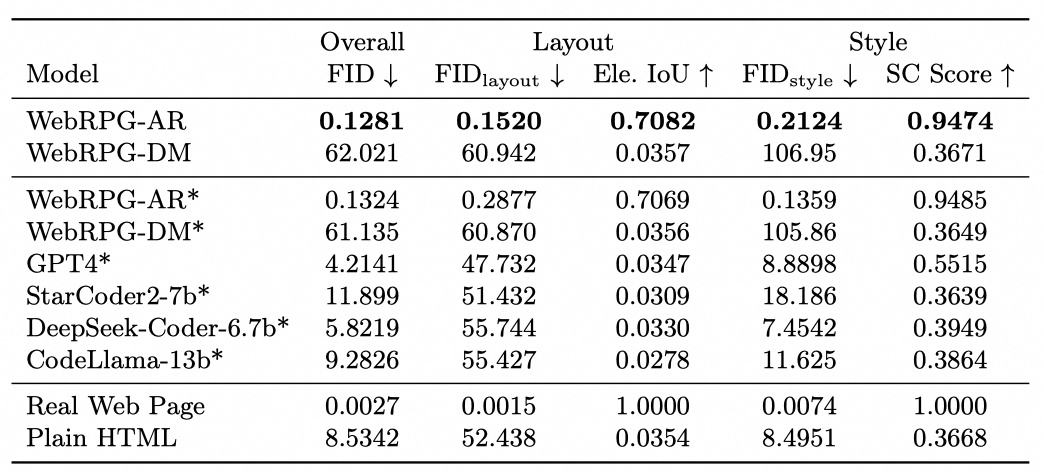

在实验方面,本文从总体外观、布局和风格三个维度对生成结果进行了定量评价。所用的指标分别为Fréchet Inception Distance (FID)、Element Intersection over Union (Ele. IoU)和Style Consistency Score (SC Score),其中SC Score是新提出的指标。除了评测基于自回归模型的WebRPG-AR和基于扩散模型的WebRPG-DM两个基线模型外,还评测了GPT-4和若干开源LLM。根据实验结果,基于自回归模型的WebRPG-AR表现最佳,可以生成合法且有效的网页视觉外观。

数据集与模型代码已在Github仓库公开,仓库地址为:

https://github.com/AlibabaResearch/AdvancedLiterateMachinery/tree/main/DocumentUnderstanding/WebRPG

隐式神经表征 (INR)作为一种能够高效表示高维数据的数据表示方法,为生成式模型等下游模型提供了强有力的工具。相对于基于梯度下降生成INR参数的方法,采用超网络预测INR 参数在推理中表现出更高的效率,已成为一种有前途且有效的替代方案。

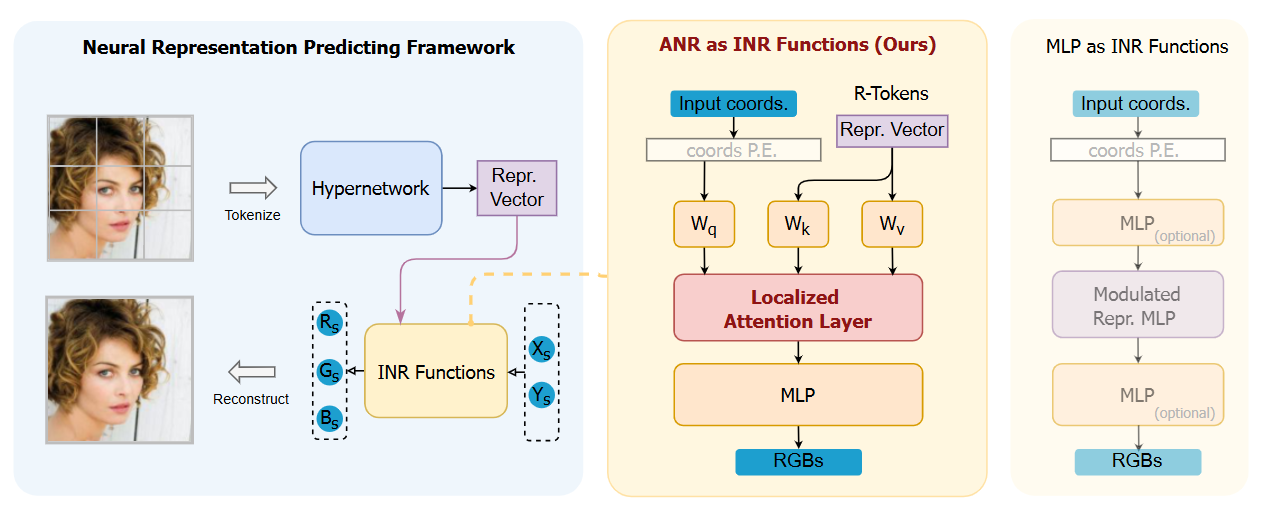

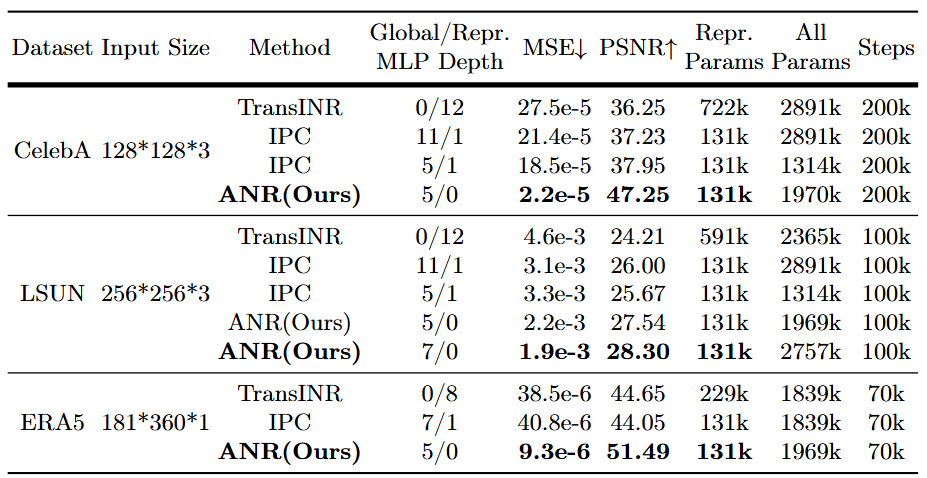

当前通常选择多层感知机(MLP)作为INR函数。作为全局连续的函数,MLP 在建模高度不连续信号方面面临了许多挑战,例如训练阶段收敛缓慢、重建结果不准确。此外,MLP 需要大量表示参数,这意味着这种数据表示形式较为低效。本文提出了一种基于局部特化注意力机制的新型 INR(ANR),由局部注意力层 (LAL)和全局 MLP 组成,它将坐标特征与数据特征相融合并将它们转换为有意义的输出。随后,我们设计了一个数据实例表示框架,该框架提供了一个类似 Transformer 的超网络,将数据实例表示为紧凑的表示向量,进而将目标信号重建为连续函数。在获得超分辨率推理结果时,我们进一步使用变分坐标解决了混叠伪影问题。实验表明,我们的模型在各种基准数据集上都能达到相当或超越当前的基线模型的效果。

论文、模型代码和相关模型参数将在Github仓库公开,仓库地址为:

https://github.com/Roninton/ANR。