Eagle实验室周晟老师论文被计算机视觉领域顶级会议ICCV2021接收

International Conference on Computer Vision (ICCV) 是计算机视觉领域的顶级会议。近期,ICCV2021会议录用结果公布,本次会议共收到6236篇有效投稿,最终录用1617篇,录用率为25.9%。Eagle实验室周晟老师的论文《Distilling Holistic Knowledge with Graph Neural Networks》被ICCV 2021录用为全文。

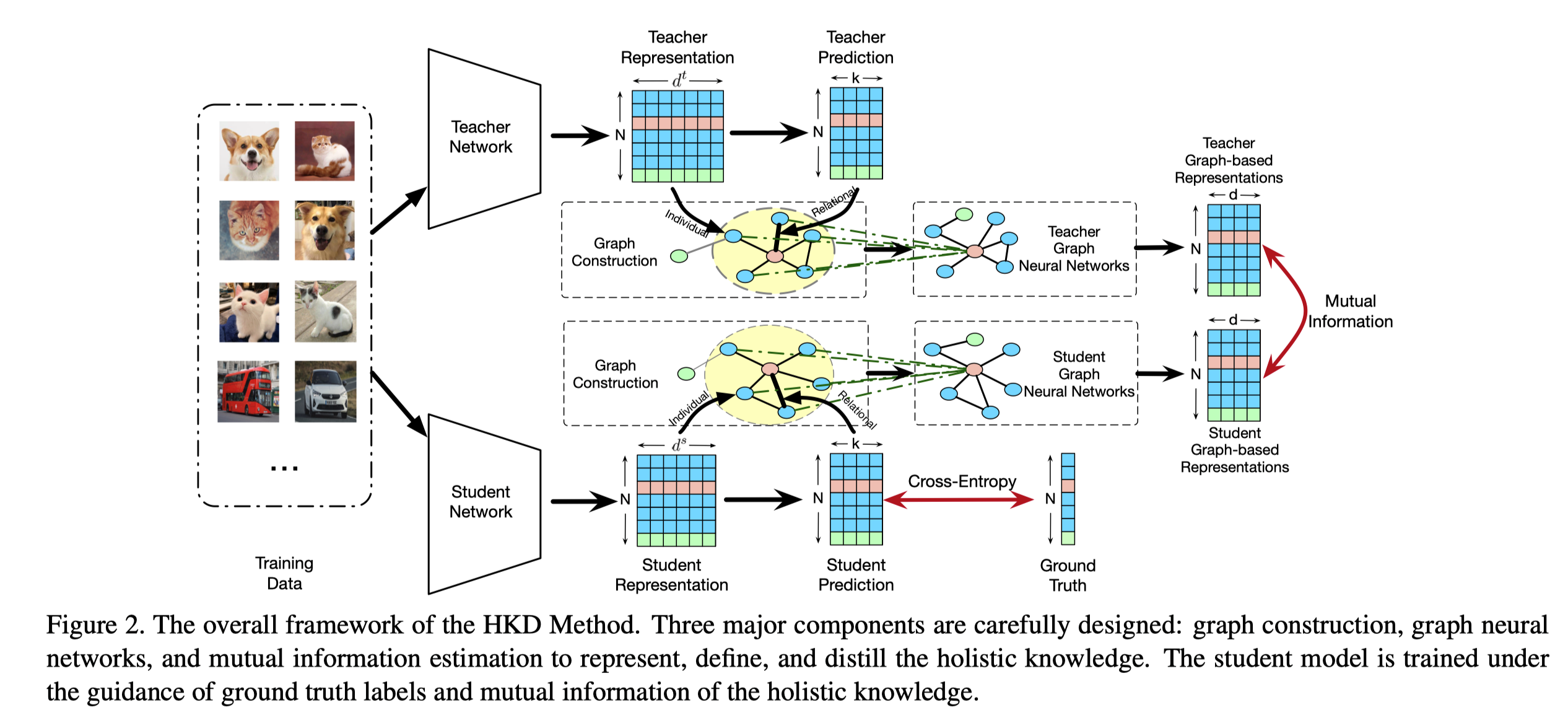

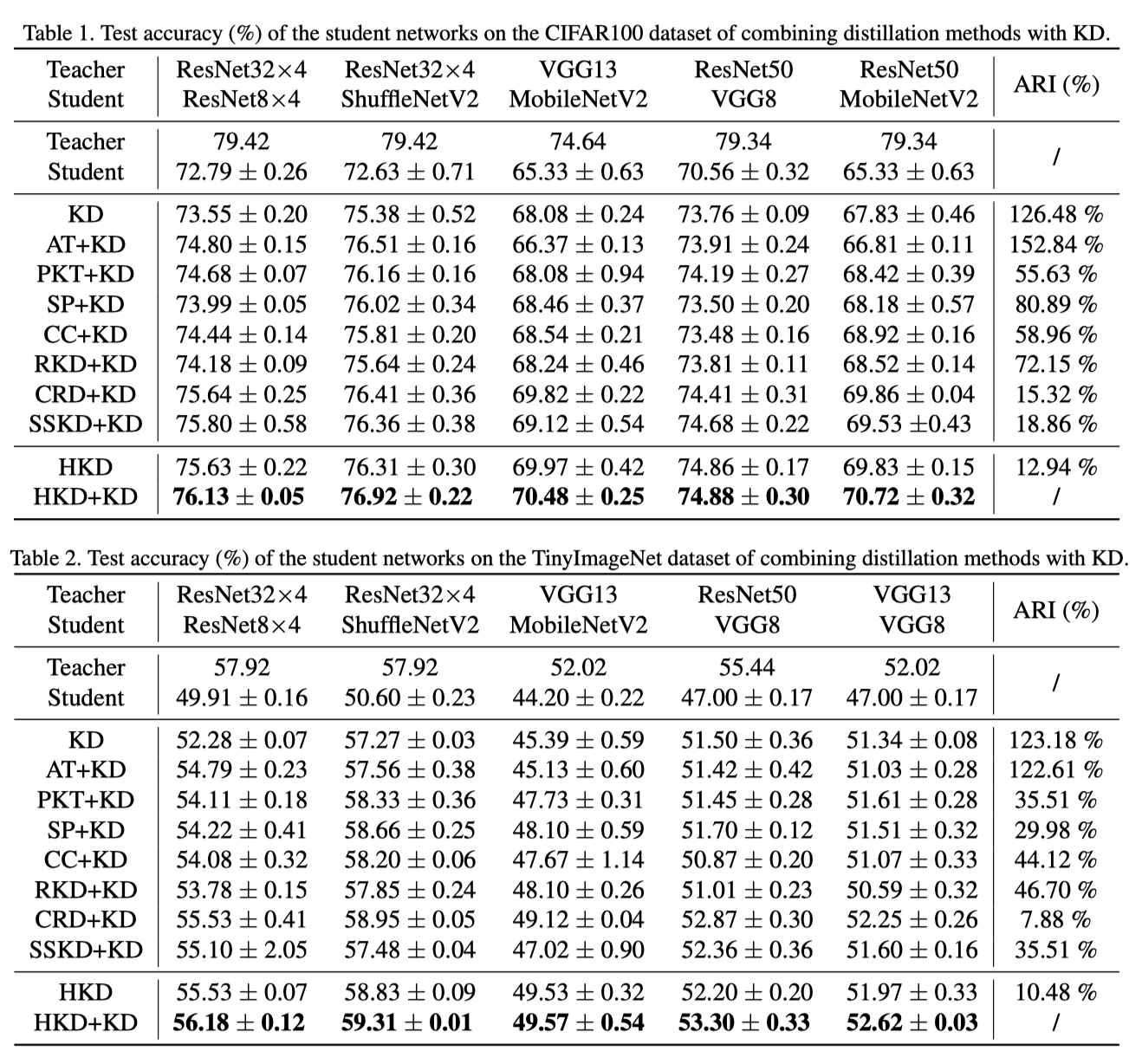

知识蒸馏作为一种模型压缩的重要技术,它通过从参数较多,效果较好的教师模型中蒸馏知识,来训练参数较少的学生模型,以提升学生网络在资源有限的设备上的性能。现有的知识蒸馏方法主要考虑两种类型的知识,即个体知识和关系知识。然而这两种知识通常以独立的方式进行建模,两种知识之间的关系则被忽略,这使得学生模型在训练时难以获得足够的知识。好的学生模型需要融合个体知识和关系知识,并保留两种信息之间的相关性。在本文中,我们提出基于实例间的属性图来从教师网络中提取整体知识。通过图神经网络从相关邻域样本中聚合个体知识,将整体知识表示为统一的基于图嵌入向量,并利用对比学习的方法来指导学生模型的训练。

本文在大量数据集上进行了性能实验和消融实验,实验结果验证了方法的有效性。

目前论文已经在Arxiv上公开:https://arxiv.org/abs/2108.05507,相关代码也已经在Github上开源:https://github.com/wyc-ruiker/HKD。